Webspecial zur Titelstory des Fraunhofer-Magazins 4.2020

Next Generation Computing

Die Digitalisierung bringt eine Datenflut mit sich, die wir mit heutigen Rechnersystemen schon bald nicht mehr effizient bewältigen können. Es ist Zeit für eine neue hybride Computing-Generation, die leistungsfähig, vertrauenswürdig und ressourceneffizient ist.

Reiternavigation

»Computer der Zukunft sind hybrid«

Das Jahr 2020 hat nicht nur eine Zäsur in Sachen Gesundheit gebracht. Auch beim Datenverbrauch hat es neue Rekorde geliefert. Marktanalysten des Branchenverbandes der Anbieter von Telekommunikations- und Mehrwertdiensten VATM schätzten im Oktober, dass in diesem Jahr 5,2 Milliarden Gigabyte allein über die deutschen Mobilfunknetze übertragen werden – eine Steigerung zum Vorjahr um 52,9 Prozent. Noch vor fünf Jahren belief sich der mobile Datenverkehr auf gerade einmal 600 Millionen Gigabyte. Durch die Festnetzleitungen rauschen im Jahr 2020 in Deutschland schätzungsweise 72 Milliarden Gigabyte – ein Plus von 28,6 Prozent.

Weltweit betrug nach Angaben des Statistischen Bundesamtes noch im Jahr 2018 das Volumen der jährlich generierten digitalen Datenmenge 33 Zettabyte. Für das Jahr 2025 prognostizieren die Statistiker mehr als eine Verfünffachung auf 175 Zettabytes. Das sind 175.000.000.000.000.000.000.000 Bytes. Zum Vergleich: Das Gesamtwerk Shakespeares umfasst, so hat es das Fachmagazin Computer Weekly einmal ausgerechnet, 5 MB, also 5 000 000 Bytes. Als nächste und letzte Einheit ist bisher nur das Yottabyte vorgesehen. Und darauf bewegt sich unsere digitale Gesellschaft kontinuierlich zu.

Vor allem Sensordaten aus dem Internet der Dinge werden – neben Videostreaming – künftig das Datenwachstum weiter vorantreiben. Künstliche Intelligenz, Industrie 4.0, autonomes Fahren – all diese digitalen Entwicklungen benötigen immer mehr Daten und damit mehr Rechenpower und Energie. Dabei wurden 2020 80 Prozent der generierten Daten noch in zentralen Systemen und 20 Prozent lokal verarbeitet, bis 2025 sollen sich diese Anteile umkehren. In dem Maße, wie der Datenberg wächst, bewegen wir uns auf die Grenzen heute existierender Computertechnologien zu. Den neuen Anforderungen an Energieverbrauch, Datenverarbeitung und Transferzeiten werden sie kaum mehr gerecht.

Die Flut an Daten ist nicht die einzige Herausforderung. Mit wachsender Abhängigkeit von digitalen Netzen und Daten steigen die Anforderungen an die Sicherheit und Resilienz der digitalen Gesellschaft. Dabei kommt vor allem der technologischen Souveränität, also der Selbstbestimmung und Kontrolle über Systeme und Daten, in Deutschland und der EU eine zentrale Rolle zu. Bislang führte die Marktmacht vor allem US-amerikanischer IT-Konzerne wie Microsoft und Google zu nahezu vollständigen Abhängigkeiten.

»Die Antwort auf diese Herausforderungen ist die Entwicklung vertrauenswürdiger, hochperformanter und ressourceneffizienter Hard- und Software«, sagt Prof. Albert Heuberger, Leiter des Fraunhofer-Instituts für Integrierte Schaltungen IIS in Erlangen. Zusammen mit seiner Kollegin Prof. Anita Schöbel vom Fraunhofer-Institut für Techno- und Wirtschaftsmathematik ITWM in Kaiserslautern verantwortet er das Thema Next Generation Computing, das die Fraunhofer-Gesellschaft als eines von sieben strategischen Forschungsfeldern definiert hat. Dabei werde es im Rechenzentrum der Zukunft mehrere Wege geben, um Probleme zu lösen, so Heuberger: »Die Zukunft liegt in hybriden, sicheren Computertechnologien, die je nach Fragestellung einzeln oder komplementär zum Einsatz kommen. Wir erforschen, welches Verfahren das beste für welche Problemstellung ist – und passen die Architektur an die jeweilige Anwendung an.« Eine zentrale Rolle beim Next Generation Computing spielen drei Schlüsseltechnologien: neuromorphe Hardware, Trusted Computing und Quantencomputing.

Neuromorphes Computing

Neuromorphes Computing

Unser Gehirn ist ein Wunderwerk. Es kann riesige Informationsmengen verarbeiten und speichern. Dabei verbraucht es nicht mehr Energie als eine 20-Watt-Glühbirne. Die neuronalen Netze, zu denen sich Millionen Nervenzellen mithilfe von Synapsen verbinden, passen sich flexibel an immer neue Lernprozesse und Erfahrungen an. Durch diese Plastizität ist das menschliche Gehirn nicht nur ein Musterbeispiel für Effizienz. Es ist heutigen KI-Systemen überlegen, die in der Regel sehr spezialisiert sind und weniger effizient.

»Wenn die Informationen direkt im System, etwa in einer neuronalen Prozesseinheit im Smartphone, gespeichert und verarbeitet werden, erhöht das die Energieeffizenz solcher Anwendungen«, so die Wissenschaftlerin. Ihr Kollege Dr. Thomas Kämpfe am Fraunhofer IPMS, der ebenfalls an der Technologie arbeitet, ergänzt: »Wir können nach Schaltkreissimulationen einzelne Rechenoperationen bei einer Latenz von einer Nanosekunde ausführen. Hinsichtlich des Stromsparpotenzials sind wir damit 100 bis 1000 Mal effizienter als etablierte KI-Hardware und noch mehr im Vergleich zu konventioneller Hardware. Durch die geringe Latenz der einzelnen Operationen können auch sehr tiefe neuronale Netze in Echtzeit berechnet werden.«

Damit hat die Technologie das Zeug dazu, eine der drängendsten Herausforderungen der Digitalisierung zu lösen: den enormen Stromverbrauch von Rechenzentren. Schon 2014 produzierte die IT-Branche weltweit so viel CO2 wie der gesamte Flugverkehr, konstatierte das Umweltbundesamt. Eine kürzlich von der EU-Kommission vorgestellte Studie zeigt, dass der Energieverbrauch von Rechenzentren in den EU-Mitgliedstaaten von 2,7 Prozent des Strombedarfs im Jahr 2018 auf 3,2 Prozent bis 2030 ansteigen wird. »Neben der lokalen Datenverarbeitung achten wir schon beim Entwurf der Elektronik auf minimalen Energieverbrauch, zum Beispiel durch intelligenten Stand-by und einen Low-Power-Schaltungsentwurf«, erklärt Dr. Mateu und verrät: »Die ersten Chips mit neuromorphem Design sollen schon 2021 in die Fertigung gehen.«

Auch im EU-Projekt NeurONN entwickelt die Fraunhofer EMFT mit sechs europäischen Partnern eine neurologisch inspirierte Computerarchitektur. Dort werden Informationen von gekoppelten oszillierenden Elementen verschlüsselt, die zu einem neuronalen Netzwerk verschaltet sind. »Analog zum Gehirn bilden die beiden Schlüsselkomponenten Neuron und Synapse die verteilten Rechen- und Speichereinheiten nach«, veranschaulicht Dr. Armin Klumpp, Projektleiter an der Fraunhofer-Einrichtung. »Als Neuronen dienen neue Elemente auf Basis von Vanadiumdioxid, die 250 Mal effizienter als modernste digitale Oszillatoren sein können. Als Synapsen kommen sogenannte Memristoren – aus memory und resistor, Speicher und elektrischer Widerstand – auf Basis von neuen 2D-Nanomaterialien zum Einsatz.« Die winzigen Bauelemente sollen bei Schaltgeschwindigkeit, Lebensdauer und Energieverbrauch bis zu 330 Mal effizienter sein als aktuelle Technologien.

Zum Einsatz sollen die neuromorphen Chips überall dort kommen, wo Energieeffizienz und niedrige Latenzzeiten besonders wichtig sind, etwa weil Geräte batteriebetrieben werden oder keine Zeit bleibt, Daten in die Cloud zu schicken und auf Antwort zu warten. So zum Beispiel bei der Analyse von Biosignalen beim EKG oder EEG, bei sogenannten »elektronischen Nasen« für Gas- und Geruchsdetektion, bei der Verarbeitung von Signalen für Sprach- oder Anomalie- Erkennung oder für Hörgeräte. Auch bei der Verarbeitung von Sensordaten – relevant beim autonomen Fahren, in Satellitenanwendungen, bei Predictive Maintanance oder Condition Monitoring in der Industrie 4.0 – kann die Signalverarbeitung mobiler und portabler Sensorsysteme wesentlich energieeffizienter werden. Ein großer Vorteil neuromorpher Hardware ist auch, dass Informationen lokal und nicht in der Cloud gespeichert werden, was sowohl die Sicherheit der Geräte als auch den Datenschutz verbessert. Nicht zuletzt dienen neuromorphe Chips als Basis für Egde-AI-Anwendungen.

Trusted Computing

Trusted Computing

Trusted Computing ist der zweite Baustein von Next Generation Computing und gleichzeitig technologisch am weitesten gediehen. »Vertrauenswürdige Elektronik und Datensicherheit sind die Basis für alle digitalen, vernetzten Systeme, speziell für das Internet der Dinge, aber auch KI«, sagt Prof. Albert Heuberger vom Fraunhofer IIS.

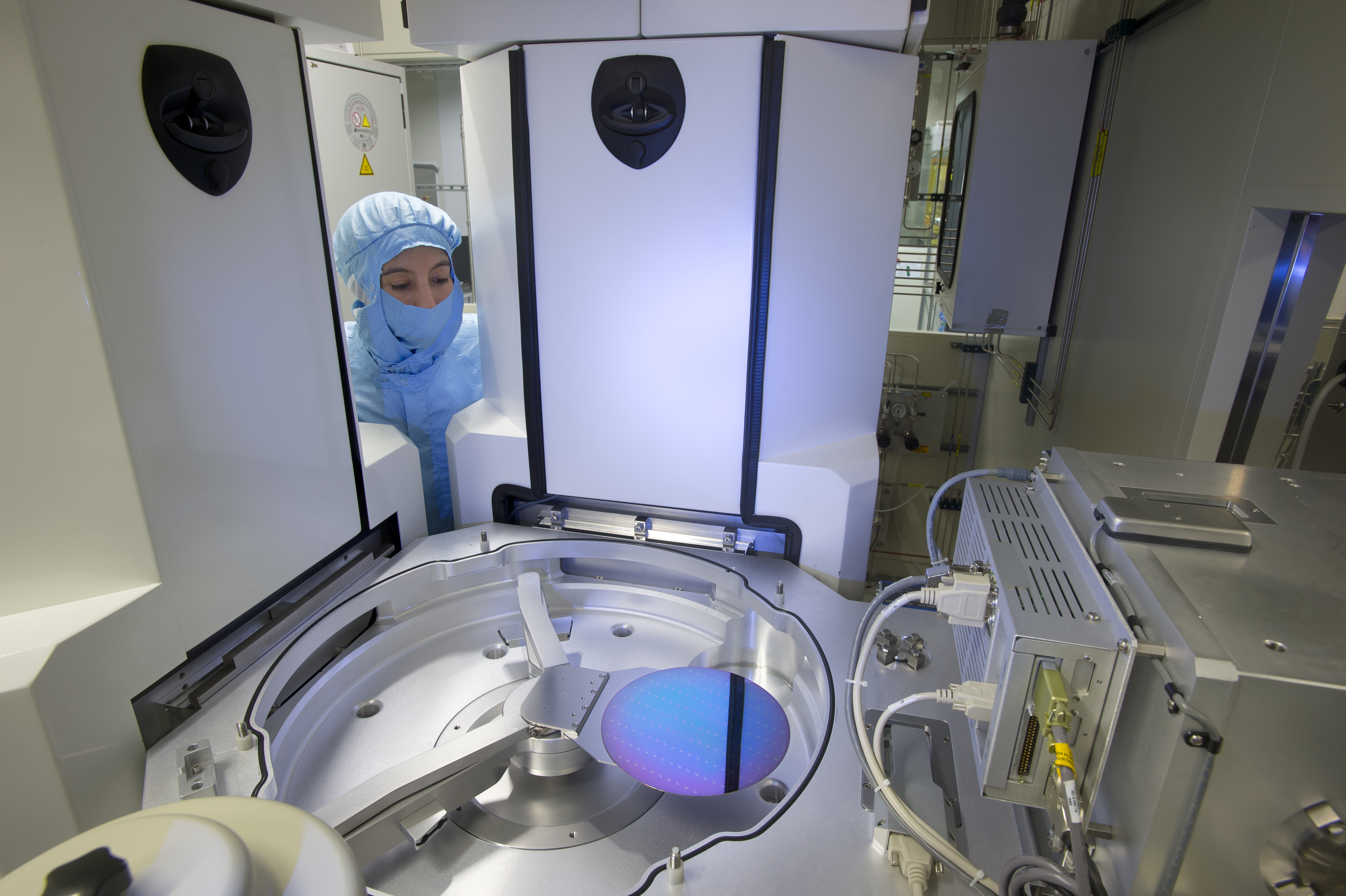

Vor allem dort, wo personenbezogene oder sicherheitskritische Daten verarbeitet werden, wie in der Medizintechnik, beim autonomen Fahren oder bei kritischen Infrastrukturen, ist es essentiell, dass die Eigentümer die vollständige Kontrolle über ihre IKT-Systeme haben und Nutzer über die Eigenschaften der von ihnen genutzten Systeme informiert werden. Betrachtet werden muss dabei der gesamte Datenfluss – vom Endkunden bis zu der eigentlichen Hardware, die die Daten verarbeitet. Gerade bei der Hardware gab es in der Vergangenheit immer wieder Sicherheitslücken, die das Auslesen sensibler Informationen ermöglichten. Erst im Frühjahr 2020 war bekannt geworden, dass es viele Intel- und AMD-Chips erlaubten, unberechtigt auf geschützte Daten zuzugreifen. Der Fehler lag schon im Design der Prozessoren. Oft sind auch nicht dokumentierte Schnittstellen oder Implementierungsfehler die Schwachstellen. »Trusted Computing umfasst deshalb nicht nur fälschungssichere Hardware und verlässliche Software, sondern beginnt bei der sicheren Halbleiterproduktion, geht über nicht auslesbare Speicherinhalte und sichere Identitäten von Rechnern bis hin zu sicheren Embedded- Systemen«, so Prof. Heuberger.

Einen weiteren kritischen Punkt spricht Dr. Patrick Bressler an, Leiter der Geschäftsstelle des Fraunhofer-Verbunds Mikroelektronik: »Viele kritische Komponenten digitaler Technologien werden heute außerhalb Europas hergestellt und in vielen Bereichen der digitalen Wertschöpfungskette besitzen ausländische Anbieter monopolähnliche Marktpositionen. Dies erzeugt eine große Abhängigkeit, die zum Nachteil Deutschlands eingesetzt werden könnte.« Das hat auch die Politik erkannt: Im Rahmen der vom Bundesministerium für Bildung und Forschung (BMBF) geförderten Initiative »Vertrauenswürdige Elektronik – Made in Germany« sollen entsprechende Standards, Normen und Prozesse auf der Grundlage einer nationalen und europäischen Chipsicherheitsarchitektur entwickelt und in die Anwendung gebracht werden. Erklärtes Ziel: Die Technologiesouveränität Deutschlands soll langfristig gestärkt werden.

Im Innovationsprogramm TRAICT (TrustedResource- Aware ICT) arbeiten 18 Fraunhofer-Institute gemeinsam an Rahmenbedingungen, damit Informations- und Kommunikationstechnik vertrauenswürdig und datenschutzkonform ist, dazu selbstbestimmt und sicher genutzt werden kann. Die Kernfrage ist: Wie lässt sich die Verlässlichkeit kritischer elektronischer Komponenten und Systeme in global verflochtenen Liefer- und Wertschöpfungsketten validieren und gewährleisten? Als übergeordnetes System wird in TRAICT ein 5G-Mobilfunkszenario gewählt, das sich aber auch auf andere Anwendungen übertragen lässt. Hierfür untersuchen die beteiligten Forscherteams Systemarchitekturen und deren Komponenten im Hinblick auf ihre Vertrauenswürdigkeit und Energieeffizienz. Mit einem transparenten Design und offengelegten Spezifikationen wollen sie den Anwendern ermöglichen, die Hardware besser zu prüfen. Ziel ist ein Überblick darüber, was genau wie implementiert ist und damit die Kontrolle über die Funktionalitäten zu behalten.

Eine wichtige Rolle spielt der Einsatz von Open-Source-Plattformen, die mehr Transparenz und die anwenderspezifische Modifizierung und genaue Prüfung des Designs erlauben. Ein Ökosystem mit Open-Source-RISC-V-Prozessoren soll es Firmen ermöglichen, eigene Hardware auch in kleineren Stückzahlen zu bauen. Zudem werden Analyseverfahren für Chips erforscht, um unerwünschte Funktionen wie etwa Hardware-Trojaner zu entdecken. Gleichzeitig wird im Projekt die Energieeffizienz optimiert – sowohl lokal in Bauelementen und -gruppen, etwa durch neue Halbleitermaterialien, als auch beim verteilten Rechnen im System durch Predictive Maintenance oder KI.

Quantencomputing

Quantencomputing

Die dritte Säule zukünftiger Rechnerarchitekturen ist das Quantencomputing. Wie kaum eine andere ist diese Technologie in den letzten Jahren zum Maßstab großer Hoffnungen geworden. Viele Staaten fördern die Forschung daran mit Milliarden, große Unternehmen und Start-ups liefern sich einen Wettlauf um die Qubits. Quantenrechner sollen künftig Probleme in Sekunden lösen, für die bisherige Computer Jahre brauchen. Dass quantenbasierte Rechner viel schneller als normale rechnen, liegt daran, dass sie quantenmechanisch verschränkte Elementarteilchen wie Elektronen oder Photonen als Informationseinheit nutzen: Qubits.

Qubits kann man sich als rotierende Teilchen vorstellen, die sich erst auf eine Drehrichtung oder Polarisierung festlegen, wenn sie gemessen werden. Solange sie nicht gemessen werden, befinden sie sich in einer sogenannten Superposition. Die einzelnen Quantenzustände können durch diesen Effekt nicht nur – wie normale Bits – die Werte 0 oder 1 annehmen, sondern gleichzeitig auch alle dazwischen. Die Teilchen lassen sich in diesem Überlagerungszustand miteinander verschränken und somit für logische Rechenoperationen nutzen. So können komplexe Aufgaben viel schneller parallel statt linear berechnet werden. Jedes zusätzliche Qubit verdoppelt dabei die Leistungsfähigkeit des Computers. »Doch Quantencomputer eignen sich längst nicht für alle Fragestellungen«, warnt Prof. Anita Schöbel, Leiterin des Fraunhofer ITWM. »Der Erfolg hängt sehr von der richtigen Rechenoperation ab, denn die Qubits skalieren nicht immer exponentiell. Wir sind nun gerade dabei zu erforschen, welche Art von Problemen wir künftig besser mit Quantencomputern lösen können und welche besser mit anderen Architekturen.«

Um das herauszufinden, hat Fraunhofer zusammen mit IBM kürzlich einen Quantencomputer, den IBM Q System One, nach Deutschland geholt – den ersten seiner Art hierzulande. Die fragile Fracht kam im November per Schiff in Deutschland an, wird nun installiert und soll im Januar 2021 im baden-württembergischen Ehningen in Betrieb gehen. »Ziel ist es, erste Anwendungen direkt zu testen und damit nicht nur unsere Kompetenzen zu erweitern, sondern die der deutschen Wirtschaft insgesamt. Wir brauchen jetzt den Zugriff auf den Quantencomputer, damit wir überhaupt die nächste Generation dieser Rechner aufbauen und bedienen können«, ist Prof. Oliver Ambacher überzeugt. Er ist Leiter des Fraunhofer-Instituts für Angewandte Festkörperphysik IAF in Freiburg und einer der Sprecher des Fraunhofer-Kompetenznetzwerks Quantencomputing. Das Netzwerk wurde gegründet als zentrale Anlaufstelle für alle, die gemeinsam mit Fraunhofer- Instituten an und mit dem Quantenrechner forschen wollen.

Die wichtigsten Fragen, auf die die Wissenschaftlerinnen und Wissenschaftler Antworten finden wollen, sind: Wie müssen Probleme beschaffen sein, um sie mit Quantencomputern effizient lösen zu können? Wie müssen die Algorithmen dafür aufgebaut sein? Und wie formuliert man Rechenmethoden auf diesen Computern, damit sie ihr Potenzial entfalten können? Ambacher vergleicht das mit den Anfängen der PCs: »Microsoft hat damals auf klassischen Computern eine Software aufgesetzt, mit der Nutzer einfach und ohne tiefe IT-Kenntnisse Briefe schreiben oder Bilder bearbeiten konnten. Analog dazu müssen wir jetzt für Quantencomputer das Gleiche leisten, um sie für eine breite Anwendung nutzbar zu machen.« Auch die Hardware ist noch Gegenstand der Forschung. Um Quantencomputer zu beherrschen und die Qubits stabil zu halten, müssen sie auf extrem niedrige Temperaturen nahe dem absoluten Nullpunkt von -273 °C gekühlt werden. Dieser Tieftemperaturbetrieb erschwert den Anschluss der Qubits an Vorspannungs-, Auslese- und Steuerelektroniksysteme, die für die Rechenprozesse nötig sind. Im EU-Projekt SEQUENCE erforschen neun Konsortialpartner, darunter Ambachers Institut Fraunhofer IAF und das Unternehmen IBM, wie Tieftemperaturanwendungen in der 3D-Nanoelektronik helfen können, Schlüsseltechnologien für Quantencomputer zu verbessern. Ein weiteres herausforderndes Problem ist die Fehleranfälligkeit der Hardware: Selbst bei den fortgeschrittensten Quantenprozessoren tritt ein Fehler bei ungefähr jeder hundertsten bis tausendsten Operation auf.

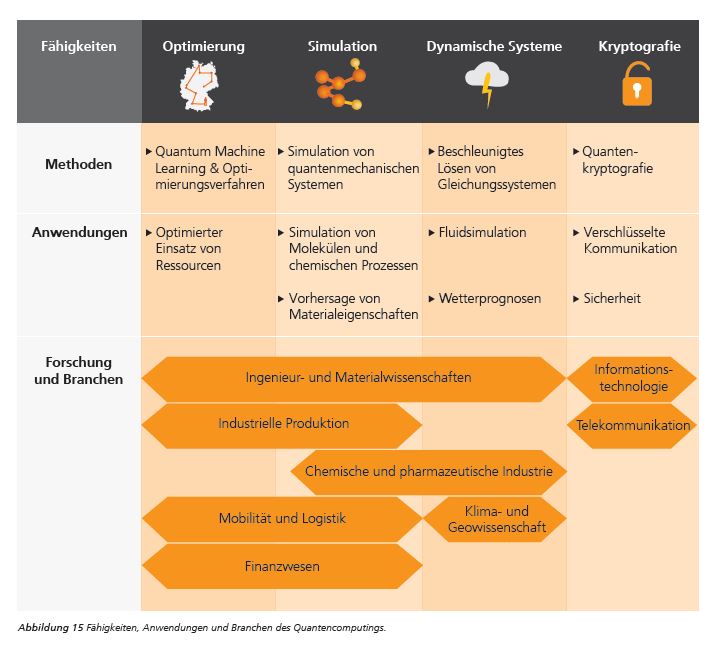

Einig sind sich die Experten, dass Quantencomputer vor allem in drei Bereichen ihre Vorteile ausspielen können, wie eine Studie der Fraunhofer-Allianz Big Data und Künstliche Intelligenz zum vielseitigen Markt- und Nutzenpotenzial von Quantencomputing jüngst zeigte:

- Sie lösen komplexe Gleichungssysteme zuverlässiger und können dadurch dynamische Systeme besser vorhersagen. Das ist entscheidend für zuverlässigere Klimamodelle und Wetterprognosen, aber auch für Betrugserkennung oder Risikoanalysen im Finanzwesen.

- Sie finden schneller Lösungen für sogenannte kombinatorische Optimierungsprobleme. Vielversprechend ist dies für große Fortschritte im maschinellen Lernen. In der Logistik lassen sich so Routen optimieren, in der Industrie Ressourcen schonender einsetzen.

- Sie können quantenmechanische Systeme genauer simulieren, da sie den gleichen Gesetzmäßigkeiten folgen. So lassen sich in Medizin und Chemie Strukturen auf kleinster Ebene erforschen sowie neue Materialeigenschaften vorhersagen.

Konkret wird es ab Januar 2021 in Baden-Württemberg, wenn die ersten Projekte mit dem IBM Q System One starten. Schwerpunkte sind dabei das Design neuer Materialien und quantenchemischer Reaktionen, die Optimierung von komplexen Zustandssystemen sowie die Entwicklung leistungsfähiger Quantenspeicher und skalierbarer Quantenprozessoren. Zu den untersuchten Anwendungsgebieten zählen unter anderem die Modellierung von Batterien und Brennstoffzellen, Stabilitätsanalysen kritischer Infrastrukturnetzwerke sowie Anwendungen und Algorithmen für Fertigung, Entwicklung, Logistik, Energie und Finanzwesen.

In Rheinland-Pfalz wollen Forschende am Fraunhofer ITWM im Verbundprojekt »EnerQuant: Energiewirtschaftliche Fundamentalmodellierung mit Quantenalgorithmen« die Vorteile von Quantencomputing für ein sehr großes Optimierungsproblem aus der Energiewirtschaft nutzen. Mithilfe des sogenannten Fundamentalmodells können Fragen beantwortet werden wie: Welche Kraftwerke werden mit welcher Kapazität zur Energieerzeugung benötigt oder welche Strompreise stellen sich an der Börse ein? Ziel ist eine hinreichend genaue stochastische Modellierung des deutschen Strommarktes. Diese wird mit dem Ausbau und der damit einhergehenden zunehmenden Einspeisung von erneuerbaren Energien immer komplexer und bedarf daher neuer Lösungsansätze.

Mit Quantencomputing ließe sich in der Zukunft dieses kombinatorische Optimierungsproblem schneller und genauer lösen, so die Hoffnung des Forschungsteams. Daher entwickeln das Fraunhofer ITWM und seine Partner dafür Algorithmen für Quantencomputer und Quantensimulatoren. Zunächst definieren sie ein einfaches Fundamentalmodell, das sich in ein quantenmechanisches Problem übersetzen und auf einem Quantensimulator darstellen lässt. Das Modell und der Quantensimulator sollen dann schrittweise weiterentwickelt werden, bis der deutsche Strommarkt genau modelliert werden kann. Als Benchmark dient ein Vergleich der Ergebnisse auf klassischen High-Performance-Computing-Systemen. Die Ergebnisse von EnerQuant werden nach Projektende für die Industrie, insbesondere die Kapital- und Energiewirtschaft, verfügbar sein.

Problem gelöst

High Performance Computing, neuromorphe Chips, Quantenprozessoren, alles in einer vertrauenswürdigen Infrastruktur – wie werden wir nun in Zukunft Probleme lösen? Prof. Anita Schöbel ist überzeugt, dass bisherige Universalcomputer in naher Zukunft zwar nicht ausgedient haben, aber durch die neuen Technologien optimiert werden: »Das Rechenzentrum der Zukunft wird heterogen sein und unterschiedlichste Anwendungen auf die verschiedene Hardware auslagern, um effiziente Ergebnisse zu erzielen. Dabei wird es auch künftig noch klassisches High Performance Computing brauchen, um etwa Quantenprozessoren zu steuern.« Sehr wahrscheinlich werden die neuen Technologien in Zukunft komplementär als Beschleuniger und für bestimmte Fragestellungen in bestehenden Computern eingesetzt. So wird auf neuromorphe Hardware zurückgegriffen, um energieeffizient neuronale Netze für die künstliche Intelligenz auszuführen. Für Simulations- und Optimierungsprozesse kommen dann Quantenprozessoren zum Zuge. »Doch letzlich wird es die Nutzerinnen und Nutzer am Ende weniger interessieren, wie genau ihr Problem gelöst, sondern nur, dass es so gut wie möglich gelöst wurde«, betont die Fraunhofer- Wissenschaftlerin und verspricht: »Dafür wollen wir mit unserer Forschung sorgen.«

- Startschuss für das EU-Projekt NeurONN (Presseinformation Fraunhofer EMFT 19.2.2020) (emft.fraunhofer.de)

- Innovationsprogramm TRAICT – Trusted Resource Aware ICT (idmt.fraunhofer.de)

- EU-Projekt SEQUENCE – Kryogene 3D-Nanoelektronik (iaf.fraunhofer.de)

- Fraunhofer und IBM bringen Quantenrechner für Industrie und Forschung nach Deutschland (Fraunhofer Presseinformation 13.3.2020) (fraunhofer.de)

- EnerQuant: Quantencomputing für die Energiewirtschaft (Presseinformation Fraunhofer ITWM 28.10.2020) (itwm.fraunhofer.de)

Weitere Projekte

Neuromorphes Computing

- Memristoren für die Rechner von Morgen / Fraunhofer ENAS (enas.fraunhofer.de)

- Neuromorphe Hardware / Fraunhofer IIS (iis.fraunhofer.de)

- Stromsparende Chips für neuromorphes Computing / Fraunhofer Fraunhofer EMFT, IIS, IPMS: Projekt Tempo (emft.fraunhofer.de)

- Projekt Andante – KI für neue Elektroniksysteme und Edge-Computing-Technologien / Fraunhofer IIS

- Projekt NeurONN – effizientes brain-like Computing / Fraunhofer EMFT (emft.fraunhofer.de)

- Ferroelektrizität in AlScN: Neu entdeckte Materialeigenschaft verspricht große Entwicklungssprünge / Fraunhofer ISIT (isit.fraunhofer.de)

- »Energieeffizientes KI-System«: Fraunhofer ADELIA-Projekt / Fraunhofer IIS, IPMS (iis.fraunhofer.de)

Trusted Computing

- »Universelle Sensor-Plattform« (USeP), mit der auch kleinere Systemanbieter den wachsenden Entwicklungs- und Fertigungsaufwand für Elektronik der nächsten Generation schultern können / Fraunhofer IIS, Institutsteil EAS (eas.iis.fraunhofer.de)

- Towards Zero Power Electronics - extrem energieeffiziente und modulare Hardware als Basis für flächendeckendes Internet der Dinge / Fraunhofer IZM

- MASSTART: Neue Verfahren zur Herstellung und Charakterisierung photonischer High-Speed-Transceiver / Fraunhofer IZM (izm.fraunhofer.de)

Quantencomputing

- Studie Quantum Machine Learning / Allianz Big Data & KI (bigdata-ai.fraunhofer.de)

- Kryogene 3D-Nanoelektronik für Quantencomputing / Fraunhofer IAF (iaf.fraunhofer.de)

- EnerQuant – Quantencomputing für die Energiewirtschaft / Fraunhofer ITWM (itwm.fraunhofer.de)

- PlanQK – Plattform und Ökosystem für Quantenunterstützte Künstliche Intelligenz / Fraunhofer FOKUS

- Quantencomputing / Fraunhofer SCAI (scai.fraunhofer.de)

- Fraunhofer Kompetenznetzwerk Quantencomputing